Alexa falsifiera les voix des vivants et des morts dans le développement de fonctionnalités

Amazon cherche à faire en sorte que l’assistant vocal d’Alexa simule profondément la voix de n’importe qui, mort ou vivant, avec juste un court enregistrement. La société a présenté la fonctionnalité lors de sa conférence re: Mars à Las Vegas mercredi, en utilisant le traumatisme émotionnel de la pandémie en cours et le chagrin pour susciter l’intérêt.

Re:Mars d’Amazon se concentre sur l’intelligence artificielle, l’apprentissage automatique, la robotique et d’autres technologies émergentes, avec des experts technologiques et des leaders de l’industrie sur scène. Au cours du discours d’ouverture de la deuxième journée, Rohit Prasad, vice-président senior et scientifique en chef d’Alexa AI chez Amazon, a présenté une fonctionnalité en cours de développement pour Alexa.

Dans la démonstration, un enfant demande à Alexa : « Est-ce que grand-mère peut finir de lire Le Magicien d’Oz pour moi ? » Alexa répond : « D’accord », de sa voix robotique efféminée typique. Mais ensuite, la voix de la grand-mère de l’enfant se fait entendre de l’orateur, qui lit un conte de fées de L. Frank Baum.

Vous pouvez regarder une démo ci-dessous :

Prasad a seulement dit qu’Amazon « travaillait » sur la capacité Alexa, et n’a pas précisé quel travail restait et quand ou s’il serait disponible.

Cependant, il a fourni les moindres détails techniques.

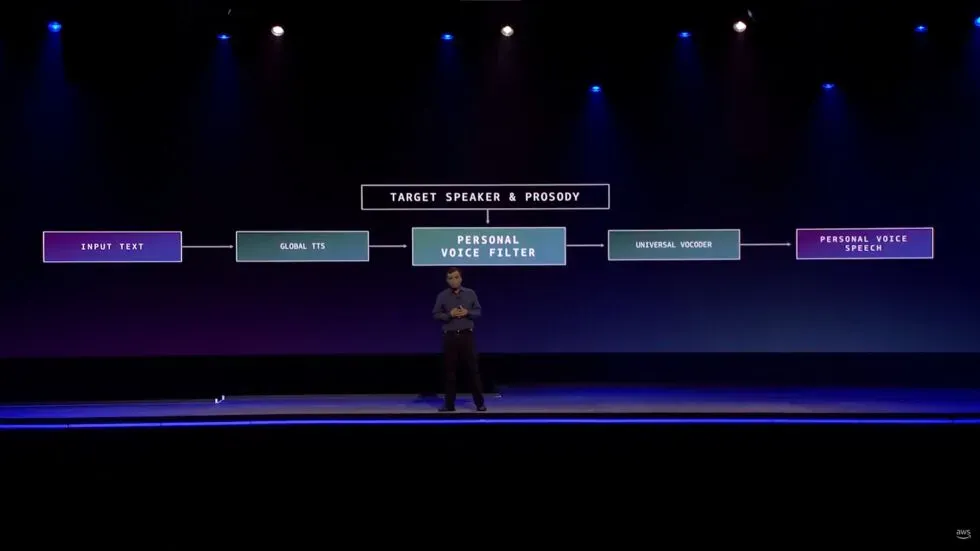

« Cela a nécessité une invention alors que nous devions apprendre à reproduire une voix de haute qualité en moins d’une minute d’enregistrement par rapport aux heures d’enregistrement en studio », a-t-il déclaré. « Nous avons rendu cela possible en définissant le problème comme un problème de conversion vocale plutôt que comme un problème de génération de parole. »

Bien sûr, les deepfakes de tous types ont généralement une réputation mitigée. Cependant, certaines tentatives ont été faites pour utiliser la technologie comme un outil plutôt que comme un véhicule pour la chair de poule.

Les deepfakes audio, en particulier, comme le note The Verge, ont été utilisés dans les médias pour compenser quand, par exemple, un podcasteur a foiré une ligne ou quand la star d’un projet est décédée subitement, comme cela s’est produit avec le documentaire Roadrunner d’Anthony Bourdain .

La publication note qu’il existe même des cas de personnes utilisant l’IA pour créer des chatbots qui communiquent comme s’ils étaient des êtres chers perdus.

Alexa ne sera même pas le premier produit grand public à utiliser l’audio deepfake pour remplacer un membre de la famille qui ne peut pas être présent en personne. Le haut-parleur intelligent Takara Tomy , comme le souligne Gi z modo , utilise l’intelligence artificielle pour lire aux enfants des histoires au coucher avec la voix d’un parent. On rapporte que les parents téléchargent leur voix en lisant le script pendant environ 15 minutes, pour ainsi dire. Bien que cela diffère nettement de la démo d’Amazon en ce que le propriétaire du produit choisit de fournir sa propre voix plutôt que le produit en utilisant la voix de quelqu’un qui ne peut probablement pas donner sa permission.

Outre les inquiétudes concernant l’utilisation de deepfakes pour des escroqueries, des vols et d’autres activités néfastes, il y a déjà des choses inquiétantes sur la façon dont Amazon construit cette fonctionnalité, qui n’a même pas encore de date de sortie.

Avant de montrer la démo, Prasad a expliqué comment Alexa offre aux utilisateurs une « relation de camaraderie ».

« Dans ce rôle de camaraderie, les qualités humaines d’empathie et d’affect sont essentielles pour instaurer la confiance », a déclaré le PDG. « Ces attributs sont devenus encore plus importants pendant la pandémie en cours, alors que beaucoup d’entre nous ont perdu quelqu’un que nous aimons. Bien que l’IA ne puisse pas éliminer cette douleur de perte, elle peut certainement prolonger leur mémoire.

Prasad a ajouté que la fonctionnalité « fournit une relation personnelle durable ».

Il est vrai que d’innombrables personnes recherchent sérieusement « l’empathie et l’affect » humains en réponse au stress émotionnel causé par la pandémie de COVID-19. Cependant, l’assistant vocal à intelligence artificielle d’Amazon n’est pas à la hauteur pour répondre à ces besoins humains. Alexa ne peut pas non plus fournir de « relations personnelles à long terme » avec des personnes qui ne sont plus avec nous.

Il n’est pas difficile de croire qu’il y a de bonnes intentions derrière cette fonctionnalité évolutive et qu’entendre la voix de la personne qui vous manque peut être un grand réconfort. Théoriquement, on pourrait même s’amuser avec une telle fonctionnalité. Faire en sorte qu’Alexa fasse entendre à un ami qu’il a dit quelque chose de stupide est inoffensif. Et, comme nous l’avons dit plus haut, il existe d’autres entreprises qui utilisent la technologie deepfake de manière similaire à ce qu’Amazon a démontré.

Mais présenter la capacité évolutive d’Alexa comme un moyen de renouer avec les membres de la famille décédés est un pas de géant, irréaliste et problématique. Pendant ce temps, toucher les cordes du cœur, provoquant le chagrin et la solitude associés à la pandémie, semble être futile. Il y a des endroits où Amazon n’appartient pas, et le conseil en cas de deuil en fait partie.

Laisser un commentaire