Alexa będzie głęboko podrabiać głosy żywych i umarłych w rozwoju funkcji

Amazon zastanawia się, jak sprawić, by asystent głosowy Alexy głęboko sfałszował głos każdego, żywego lub martwego, za pomocą krótkiego nagrania. Firma zaprezentowała tę funkcję na swojej konferencji re:Mars w Las Vegas w środę, wykorzystując emocjonalną traumę związaną z trwającą pandemią i żalem, aby wzbudzić zainteresowanie.

Amazon’s Re:Mars koncentruje się na sztucznej inteligencji, uczeniu maszynowym, robotyce i innych pojawiających się technologiach, z udziałem ekspertów technicznych i liderów branży. Podczas przemówienia drugiego dnia Rohit Prasad, starszy wiceprezes i główny naukowiec Alexa AI w Amazon, zaprezentował funkcję opracowywaną obecnie dla Alexy.

Podczas demonstracji dziecko pyta Alexę: „Czy babcia może dokończyć dla mnie czytanie Czarnoksiężnika z krainy Oz?” Alexa odpowiada: „Dobrze” swoim typowym zniewieściałym głosem robota. Ale wtedy z głośnika rozlega się głos babci dziecka, która czyta bajkę L. Franka Bauma.

Demo można obejrzeć poniżej:

Prasad powiedział tylko, że Amazon „pracuje” nad możliwościami Alexy i nie wyjaśnił, jakie prace pozostały oraz kiedy i czy będą dostępne.

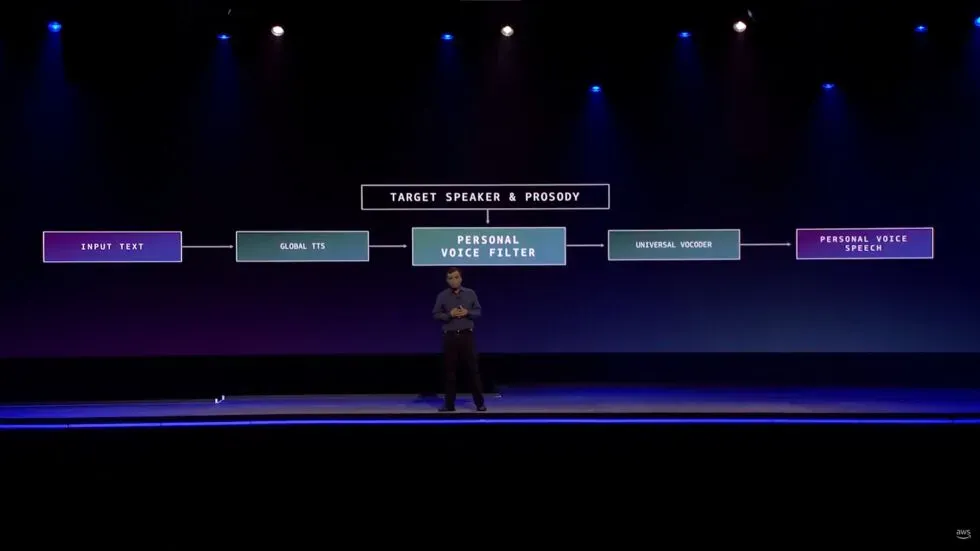

Podał jednak najdrobniejsze szczegóły techniczne.

„Wymagało to inwencji, gdy musieliśmy nauczyć się odtwarzać wysokiej jakości głos w czasie krótszym niż minuta nagrania w porównaniu z godzinami nagrywania w studio” — powiedział. „Umożliwiliśmy to, opisując problem jako problem z konwersją głosu, a nie problem z generowaniem mowy”.

Oczywiście wszelkie rodzaje deepfake’ów mają generalnie mieszaną reputację. Jednak podjęto pewne próby wykorzystania tej technologii jako narzędzia, a nie narzędzia do przerażania.

W szczególności deepfake audio, jak zauważa The Verge, był używany w mediach, aby nadrobić, na przykład, gdy podcaster pomylił linię lub gdy gwiazda projektu nagle zmarła, jak to miało miejsce w przypadku filmu dokumentalnego Roadrunner Anthony’ego Bourdaina .

W publikacji zauważono, że zdarzają się nawet przypadki osób wykorzystujących sztuczną inteligencję do tworzenia chatbotów , które komunikują się tak, jakby były utraconymi bliskimi.

Alexa nie będzie nawet pierwszym produktem konsumenckim, który wykorzystuje dźwięk deepfake, aby zastąpić członka rodziny, który nie może być obecny osobiście. Inteligentny głośnik Takara Tomy , jak wskazuje Gi z modo , wykorzystuje sztuczną inteligencję do czytania dzieciom bajek na dobranoc głosem rodzica. Podobno rodzice przesyłają swoje głosy, czytając scenariusz przez około 15 minut, że tak powiem. Chociaż różni się to znacznie od demo Amazona tym, że właściciel produktu decyduje się na zapewnienie własnego wokalu, a nie produktu przy użyciu głosu kogoś, kto prawdopodobnie nie może wyrazić zgody.

Oprócz obaw związanych z wykorzystywaniem deepfake’ów do oszustw, rabunków i innych nikczemnych działań, istnieją już pewne niepokojące rzeczy dotyczące tego, jak Amazon buduje tę funkcję, która nie ma jeszcze nawet daty premiery.

Przed pokazaniem wersji demonstracyjnej Prasad mówił o tym, jak Alexa zapewnia użytkownikom „relację koleżeńską”.

„W tej koleżeńskiej roli ludzkie cechy, takie jak empatia i afekt, są kluczem do budowania zaufania” — powiedział dyrektor generalny. „Te atrybuty stały się jeszcze ważniejsze podczas trwającej pandemii, kiedy wielu z nas straciło kogoś, kogo kochali. Chociaż sztuczna inteligencja nie może wyeliminować bólu związanego ze stratą, zdecydowanie może wydłużyć ich pamięć”.

Prasad dodał, że ta funkcja „zapewnia trwały związek osobisty”.

Prawdą jest, że niezliczone osoby poważnie poszukują ludzkiej „empatii i afektu” w odpowiedzi na stres emocjonalny spowodowany pandemią COVID-19. Jednak asystent głosowy sztucznej inteligencji Amazona nie jest w stanie sprostać tym ludzkim potrzebom. Alexa nie może również zapewniać „długoterminowych relacji osobistych” z osobami, których już z nami nie ma.

Nietrudno uwierzyć, że za tą ewoluującą funkcją stoją dobre intencje, a usłyszenie głosu osoby, za którą tęsknisz, może być wielką pociechą. Teoretycznie taką funkcją moglibyśmy się nawet pobawić. Sprawianie, że Alexa sprawia, że przyjaciel brzmi tak, jakby powiedział coś głupiego, jest nieszkodliwe. Jak powiedzieliśmy powyżej, istnieją inne firmy wykorzystujące technologię deepfake w sposób podobny do tego, który zademonstrował Amazon.

Ale przedstawienie ewoluującej zdolności Alexy jako sposobu na ponowne połączenie się ze zmarłymi członkami rodziny jest gigantycznym, nierealistycznym i problematycznym skokiem. Tymczasem dotykanie strun serca, wywołujące smutek i samotność związaną z pandemią, wydaje się daremne. Są miejsca, do których Amazon nie należy, a poradnictwo żałobne jest jednym z nich.

Dodaj komentarz