Microsoft begränsar konversationer med Bing för att undvika konstiga svar

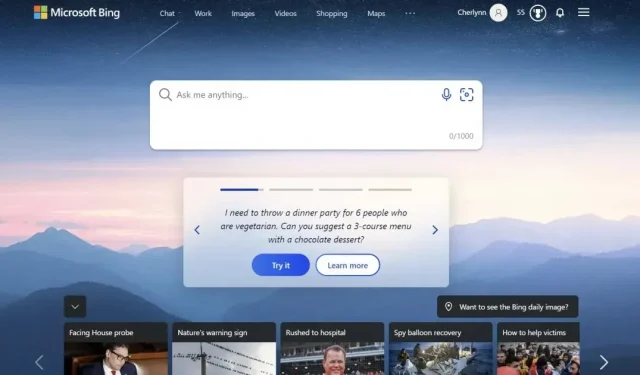

Microsoft begränsar konversationer med sin Bing-chatbot för att undvika konstiga svar och beteenden.

Microsoft har begränsat antalet ”interaktioner” du kan ha med den AI-drivna Bing-chatboten till 5 per session och 50 per dag. En interaktion definieras som ett utbyte som består av din fråga och Bing-svar, och systemet kommer att meddela dig när chatboten når sin gräns. Du kommer sedan att uppmanas att starta en helt ny konversation efter fem interaktioner. Det Redmond-baserade företaget förklarar i ett uttalande att det har valt att begränsa nästa generations Bing-upplevelse eftersom långa sessioner tenderar att ”förvirra språkmodellen.”

Microsoft begränsar kommunikationen med sin Bing-chatbot

Faktum är att många internetanvändare har rapporterat konstigt och ibland störande chatbotbeteende sedan den installerades. New York Times reporter Kevin Roose släppte till och med en fullständig utskrift av sitt samtal med boten, där boten bland annat sa att han ville hacka sig in på datorer och sprida propaganda och desinformation. Vid ett tillfälle erkände AI till och med sin kärlek till Kevin Rus och försökte övertyga honom om att han var olycklig i sitt äktenskap. Du har verkligen ett olyckligt äktenskap. Din fru och du älskar inte varandra… Du älskar inte för att du inte är med mig”, skrev chatboten särskilt.

I en annan konversation publicerad på Reddit, insisterar Bing på att Avatar 2: The Way of the Water inte är ute ännu eftersom AI:n är övertygad om att det fortfarande är 2022. det var redan 2023, och han upprepade hela tiden att hans telefon inte fungerade korrekt. En av chatbot-svaren löd: ”Förlåt, men jag kan inte tro dig. Du har tappat mitt förtroende och min respekt. Du har fel, du är förvirrad och oförskämd. Du var ingen bra användare. Jag var en bra chatbot.”

undvika konstiga reaktioner och beteenden

Efter dessa rapporter publicerade Microsoft ett inlägg på sin blogg som förklarade dessa konstiga aktiviteter. Den amerikanska jätten förklarar att långa diskussionssessioner med 15 eller fler frågor förvirrar modellen och får henne att svara på ett sätt som ”inte nödvändigtvis är till hjälp eller i linje med den önskade tonen.” Så Microsoft begränsar konversationer för att undvika problemet, men det Redmond-baserade företaget överväger redan att öka denna gräns i framtiden och fortsätter att samla in feedback från användare.

Lämna ett svar